Ahora que ya sabéis lo que es el Crawl Budget y la importancia que tiene a la hora de posicionar una página web, os traemos unos consejos de cómo podemos optimizarlo para que los Crawlers dediquen más tiempo a rastrear nuestra web.

¿Cómo aumentar la frecuencia de rastreo?

A parte de que los crawlers dediquen de forma eficiente el tiempo que están en la web, otro de los puntos que hay que mejorar es aumentar la frecuencia de visitas de los Crawlers de Google a nuestro sitio web.

Hay una gran variedad de caminos para optimizar la periodicidad de rastreo de una web. Estas son algunas de las que mejor funcionan:

- Crear nuevas páginas e ir modificando el contenido de las que ya tenemos subidas, para que Google vea continuas mejoras, con un contenido original.

- Aumentar de forma periódica, el número de enlaces externos que apuntan hacia la página web.

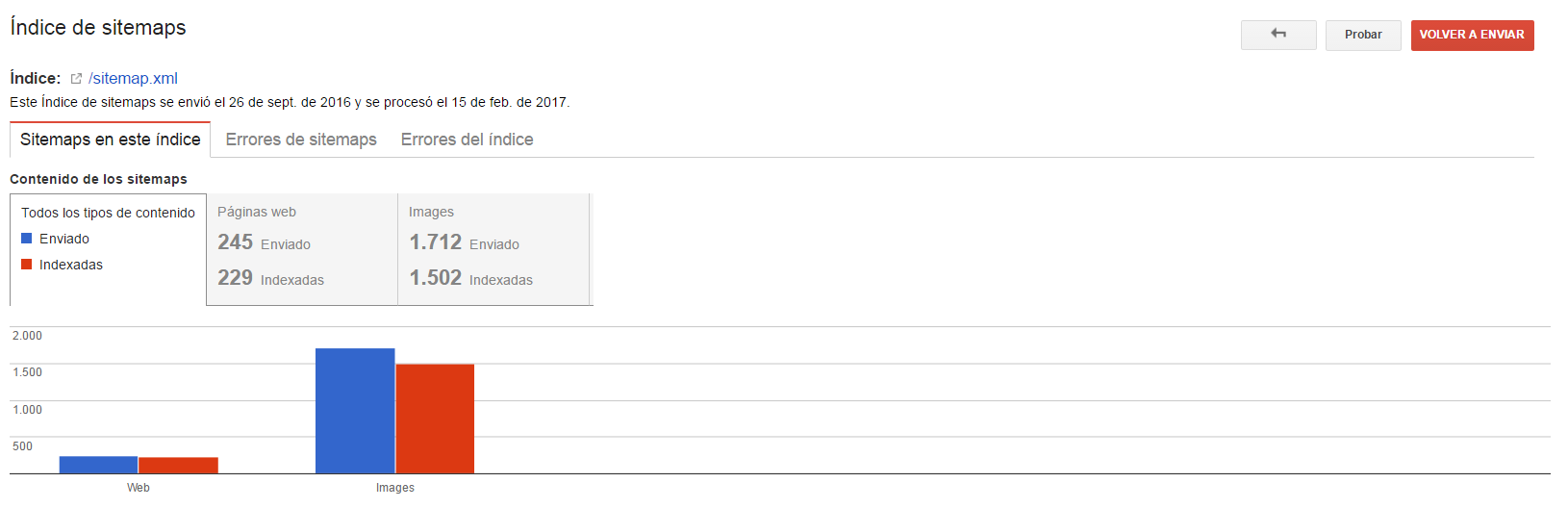

- Actualizar el o los sitemaps de vuestra web y hacerle lo que se llama un “ping” a Google, un aviso para que GoogleBot rastree la página.

¿Cómo optimizar al máximo el crawl budget?

Para optimizar el Crawl Budget, lo primero que hay que hacer es mejorar la arquitectura de la web y decirle al crawler que páginas queremos que indexe y potencie (esto se hace vía robots.txt).

Estas son las acciones que recomiendo que se realicen para lograr optimziar al máximo el Crawl Budget:

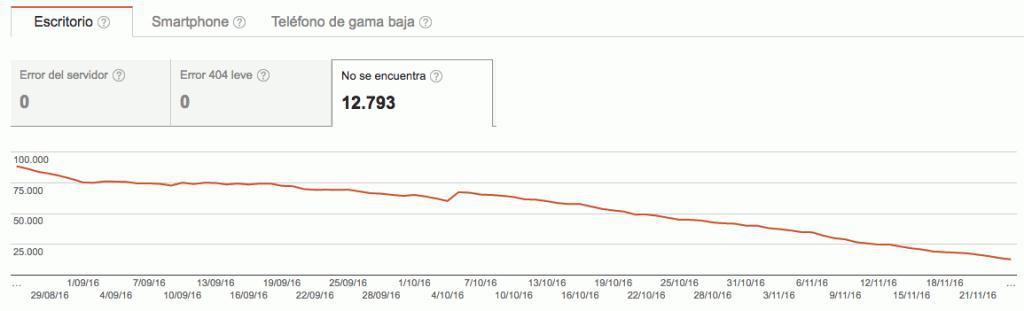

- Encontrar y solucionar las páginas que tengan errores 4xx y 5xx, para no hacer perder el tiempo al crawler en visitar páginas que no existen.

- Optimizar la estructura y el enlazado interno de la página web, siempre apuntando a URLs finales que muestren contenido.

- Detectar y eliminar el contenido duplicado (modificar los textos y crear contenido fresco y original).

- Dar uso al archivo robots.txt de la web, evitando así hacer perder el tiempo al crawler en páginas sin provecho.

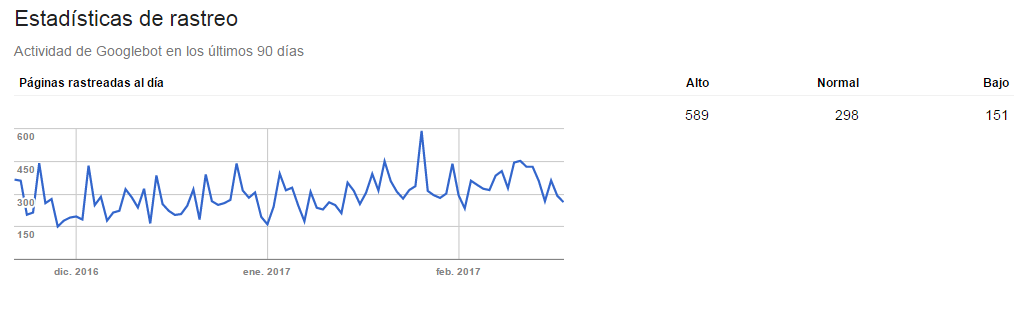

Existen un sinfín de herramientas que nos dicen cuántas veces ha visitado Google nuestra web y qué páginas está visitando, para ello podéis usar Google Search Console o Screaming Frog.

Existe una herramienta poco conocida, llamada Simple SERP Screaper, la cual ayuda en la gestión de la indexación de las Urls de la web. La herramienta nos dirá que Urls está indexando Google de nuestro sitio web, podremos exportarlas a un excel y ver aquellas urls que no nos interesan y eliminarlas mediante Webmaster Tools.

Por nuestra experiencia, toda web que cuenta con un Crawl Budget mayor, están mejor posicionadas que otras páginas en las que los crawlers las rastrean en menos ocasiones.